Будущее медицины

Отрывок из книги профессора геномики Эрика Тополя об индивидуальных предсказаниях болезней, искусственном интеллекте в современной медицине и прогнозах эпидемий

Совместно с издательством Альпина нон-фикшн мы публикуем отрывок из книги «Будущее медицины. Ваше здоровье в ваших руках» врача, ученого, профессора геномики Эрика Тополя, посвященной современным методам лечения, информационным технологиям в медицине и новым форматам общения между врачом и пациентом.

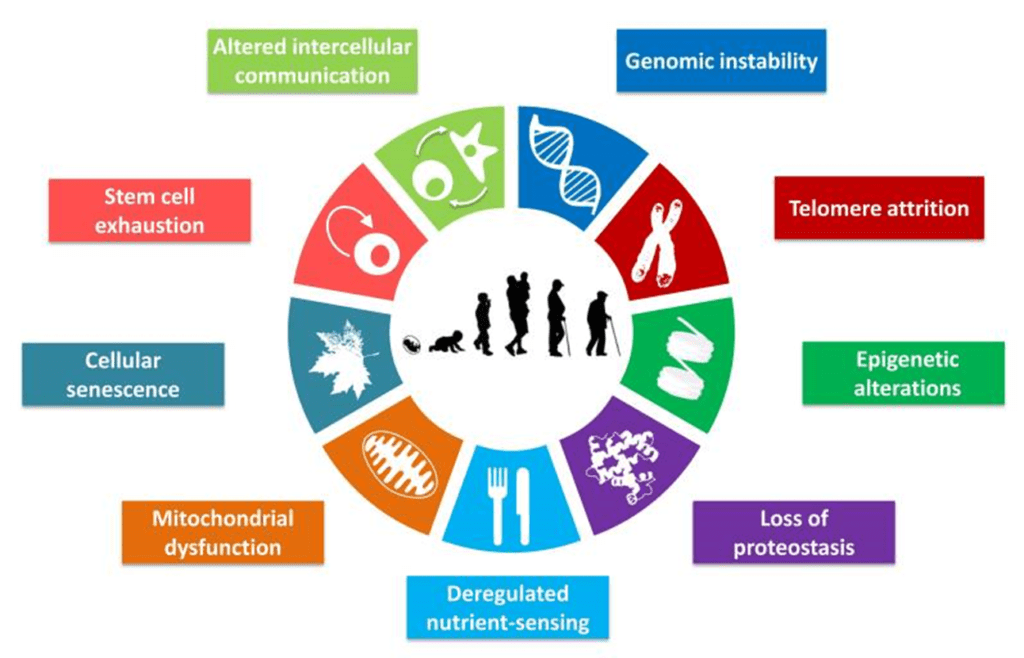

Самая большая неосуществимая мечта в здравоохранении — предотвращение хронических болезней. В США мы тратим 80% из почти $3 трлн ежегодно выделяемых на здравоохранение на то, чтобы справиться с грузом хронических болезней. А что, если бы был способ остановить их на этапе развития?

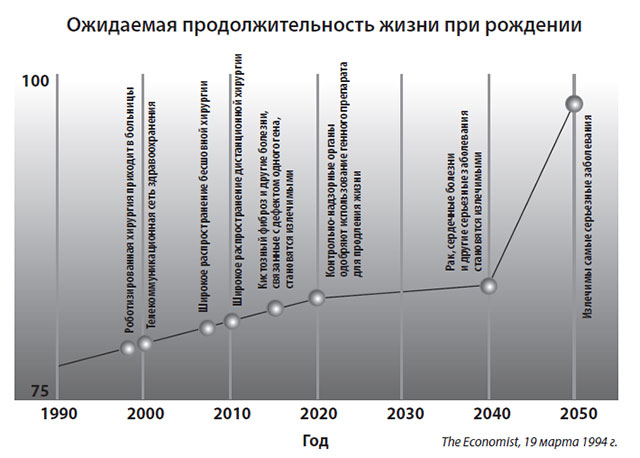

В медицине есть и другие большие мечты. До сих пор не могу забыть один график, который видел в The Economist (рис. 13.1) более 20 лет назад. В 1994 г. журнал предсказывал, что рак и сердечные болезни станут «излечимыми» к 2040 г., а остальные самые серьезные болезни — к 2050-му. При этом ожидаемая продолжительность жизни при рождении вырастет до 100 лет. Все это казалось набором слишком смелых ожиданий, и многие из них и сегодня не стали более реальными, чем были в 1994 г. Некоторые пророчества, по крайней мере частично, воплощены в жизнь — например, роботизированная хирургия и эффективное лечение некоторых видов кистозного фиброза. Но, безусловно, это еще не «излечимость». Вероятно, это и не должно удивлять. Слово «излечение» обычно означает «восстановление здоровья», или «выздоровление после болезни», или «облегчение симптомов болезни или состояния».

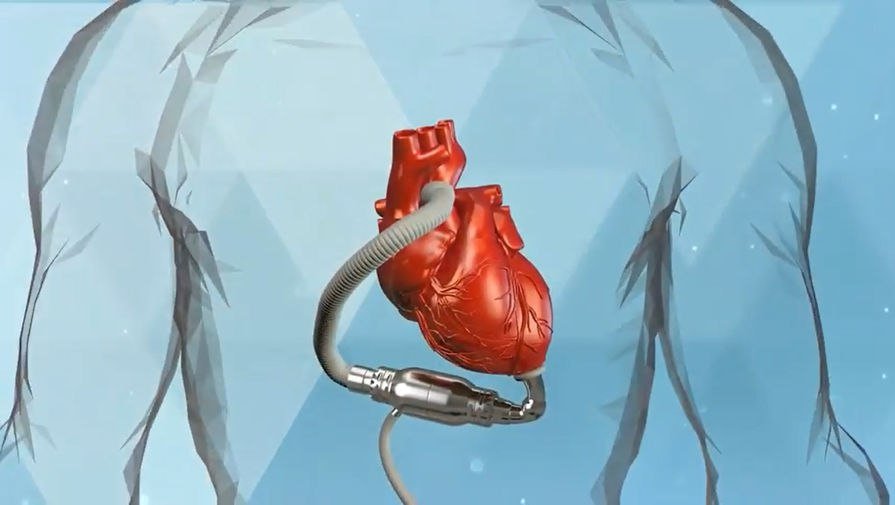

В медицине «излечений» поразительно мало. Некоторые из примеров — это снятие аритмии типа фибрилляции предсердий (у некоторых пациентов, которым повезло), антибиотики в случае пневмонии или один из новых видов лечения гепатита C с выздоровлением в 99% случаев (для самого широко распространенного генотипа-1, вирусного подвида). Обычно, когда человека настигает болезнь, с ней надо как-то справляться. На самом деле, несмотря на предсказания The Economist, большинство ученых, которые активно занимаются поиском способов лечения рака, надеются превратить его в хроническую болезнь: они уже умерили свои амбиции в отношении излечения. Когда наступает застойная сердечная недостаточность, хроническая обструктивная болезнь легких (ХОБЛ), почечная недостаточность, цирроз, деменция или серьезная недостаточность в работе какого-либо органа, на самом деле надежды на излечение нет.

Рис. 13.1. Увеличение ожидаемой продолжительности жизни при рождении и прогноз по «излечимости» большинства болезней. Источник: адаптировано из “A Survey of the Future of Medicine,” The Economist, March 19, 1994, http://www.highbeam.com/doc/1G1–15236568.html

Рис. 13.1. Увеличение ожидаемой продолжительности жизни при рождении и прогноз по «излечимости» большинства болезней. Источник: адаптировано из “A Survey of the Future of Medicine,” The Economist, March 19, 1994, http://www.highbeam.com/doc/1G1–15236568.htmlЭто представляется весьма мрачным прогнозом. Но теперь, с приходом больших данных, неуправляемых алгоритмов, предиктивной аналитики, обучения машин, расширенной реальности и нейроморфных вычислений, медицина преобразуется в науку о данных. Все еще есть возможность изменить медицину к лучшему, и по крайней мере есть шанс на предупреждение болезней. То есть, если имеется точный сигнал перед тем, как болезнь когда-либо проявлялась у человека — и эта информация дает веские основания для действий, — болезнь можно предотвратить.

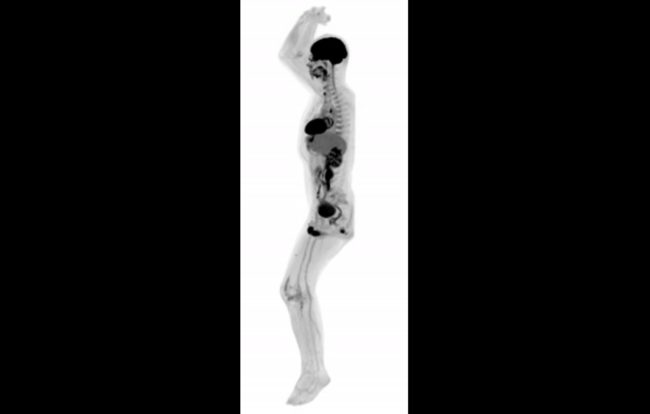

Однако эта мечта — не просто вопрос совершенствования науки о данных. Она косвенно связана с демократизацией медицины. Перспективы здесь невозможны без освоения людьми искусства наблюдения за самими собой — вспомните двойной смысл термина «персонализированная медицина». Улавливание сигнала задолго до того, как появляются какие-либо симптомы, зависит от ГИС человека, а не от ежегодных посещений врача. С помощью маленьких беспроводных устройств, которые мы носим с собой, и Интернета вещей мы развиваем способность к непрерывному, очень важному наблюдению за нашими телами в режиме реального времени. Для времени, когда такая способность будет развита в полной мере (а в конечном счете это случится), предсказания The Economist на следующие 30 лет в медицине не кажутся такими уж притянутыми за уши.

The Economist, можно сказать, погорячился, делая в 1994 г. такие прогнозы. Термины «углубленный анализ данных» и «предиктивная аналитика» определенно еще не были в моде и, вероятно, еще не были изобретены. Но концепция использования данных для предсказаний, как, например, актуарная (страховая) статистика на случай страховая жизни, используется уже очень давно. Отличие состоит в том, что наборы данных теперь цифровые, значительно больше и богаче и им соответствуют поразительная вычислительная мощность и алгоритмическая обработка. Именно это дало возможность Target предсказывать беременность некоторых своих покупательниц, Агентство национальной безопасности использует распечатки звонков с наших телефонов для выявления террористов, а больницы прогнозируют, кому из пациентов с застойной сердечной недостаточностью потребуется госпитализация. И именно это позволит нам «не рубить сплеча».

Предсказания на уровне населения

Некоторые вещи предсказать легко и делается это интуитивно. Примером может служить ситуация, когда болезнь публичного лица заставляет других людей искать в Интернете информацию об этой болезни или ее лечении. Можно легко предсказать, что это случится, а поисковая активность просто отражает количественную сторону дела.

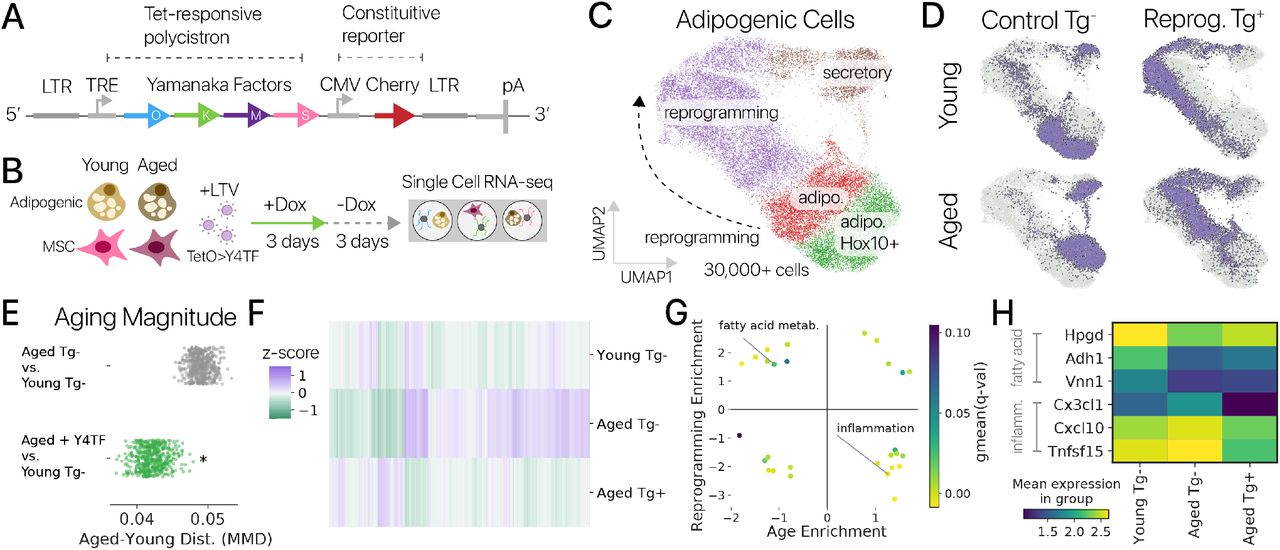

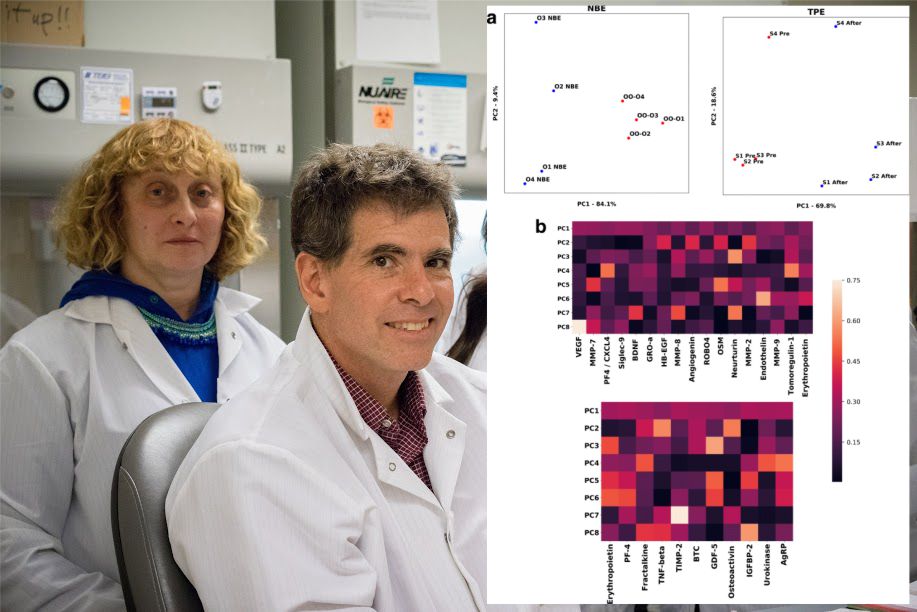

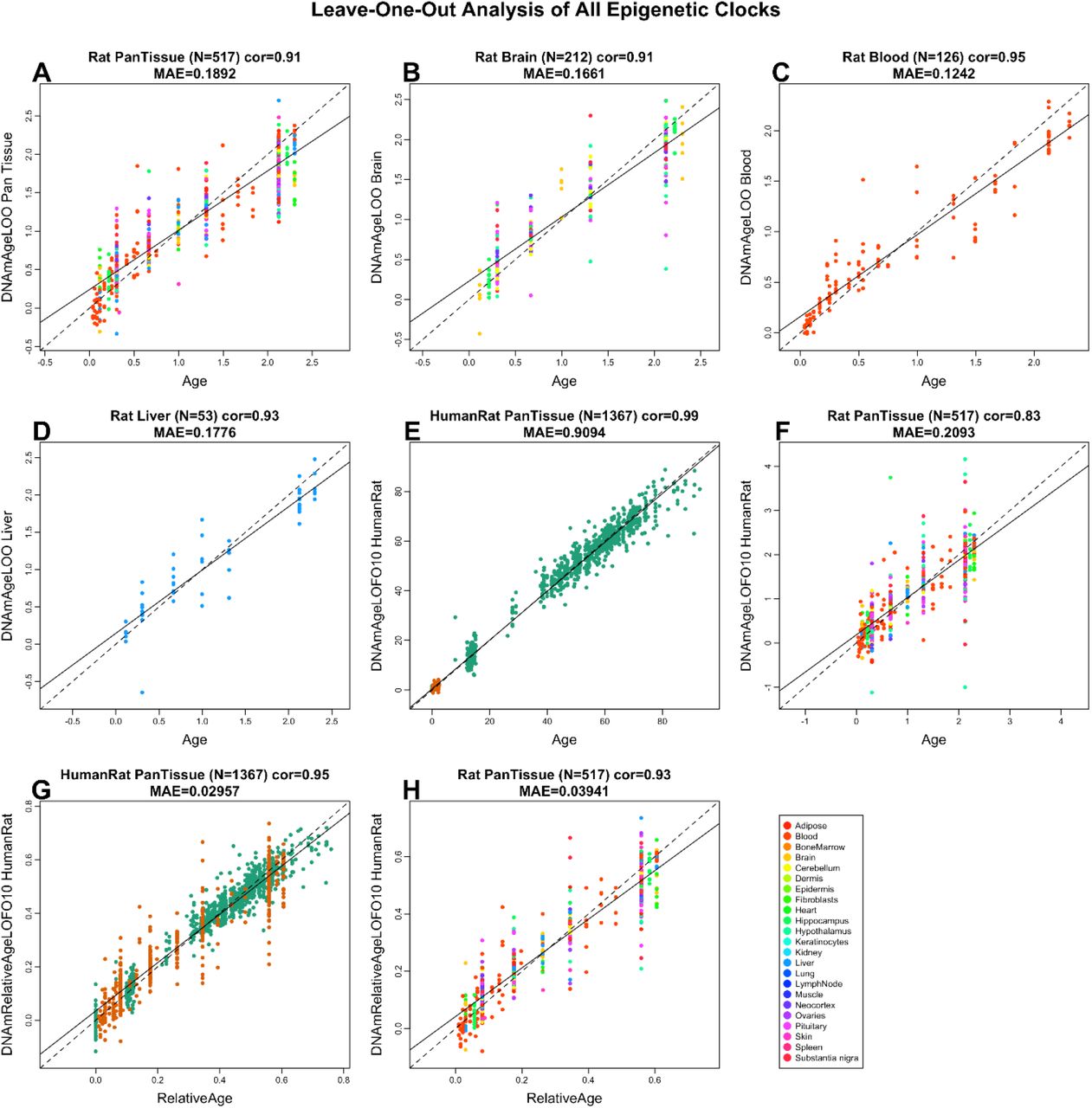

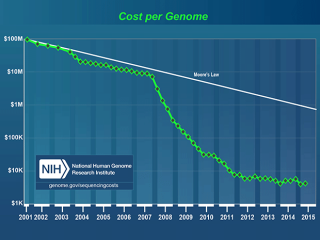

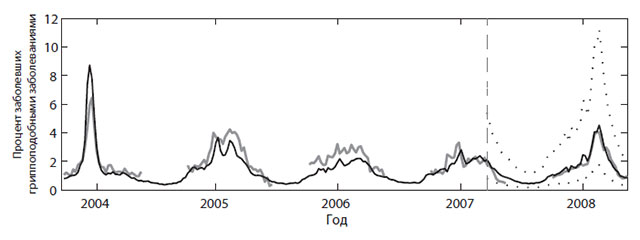

А что, если вы используете поисковики Google, чтобы с умом предсказывать болезнь, а не просто определить количество запросов? Это приводит нас к известной истории о гриппе, связанной с Google, — одному из самых цитируемых примеров предсказаний в здравоохранении. Инициатива Google Flu Trends («Тенденции гриппа от Google») была запущена в 2008 г. и стала известна как «живой пример силы анализа больших данных». Сначала отслеживались 45 терминов, связанных с поиском информации по гриппу, и тенденции в миллиардах поисковых запросов в 29 странах. Потом были выведены соответствия с помощью неуправляемых алгоритмов для предсказания начала эпидемии гриппа. Под неуправляемостью имеется в виду отсутствие заданной гипотезы — просто 50 млн поисковых терминов и алгоритмов делают свою работу. В широко цитируемых статьях в Nature и Public Library of Science (PLos) One авторы из Google (рис. 13.2) заявляли о своей способности использовать журналы поиска в Интернете для создания ежедневных оценок заражения гриппом, в отличие от обычных методов, которые предусматривают временной лаг от одной до двух недель. И далее, в 2011 г.: «Инициатива Google Flu Trends может обеспечить своевременные и точные оценки заболеваемости гриппом в США, в особенности во время пика эпидемии, даже в случае новой формы гриппа».

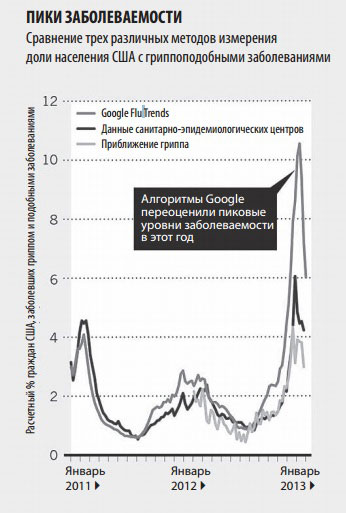

Но начало 2013 г. сопровождалось бурей противоречий: оказалось, что Google Flu Trends сильно переоценила вспышку гриппа (рис. 13.3). В дальнейшем группа из четырех очень уважаемых специалистов по обработке и анализу данных написала в Science, что Google Flu Trends систематически переоценивала распространение гриппа каждую неделю начиная с августа 2011 г. Далее эта группа критиковала «высокомерие больших данных», «распространенное представление, что большие данные скорее заменяют, чем дополняют традиционный сбор и анализ данных.

Рис. 13.2. Данные санитарно-эпидемиологических центров (светлая линия) в сравнении с данными Google Flu Trends (темная линия) по вспышкам гриппа в среднеатлантических штатах США. Источник: J. Ginsberg et al., “Detecting Influenza Epidemic Using Search Engine Query Data,” Nature 457 (2009): 1012–1015. Перепечатывается с разрешения

Рис. 13.2. Данные санитарно-эпидемиологических центров (светлая линия) в сравнении с данными Google Flu Trends (темная линия) по вспышкам гриппа в среднеатлантических штатах США. Источник: J. Ginsberg et al., “Detecting Influenza Epidemic Using Search Engine Query Data,” Nature 457 (2009): 1012–1015. Перепечатывается с разрешения

Они ругали «динамику алгоритма» Google Flu Trends (GFT), указывая, что 45 терминов, используемых в поисковых запросах, не были документированы, ключевые элементы, как, например, основные условия поиска, не были представлены в публикациях, а изначальный алгоритм не подвергался постоянным настройкам и перепроверке. Более того, хотя алгоритм GFT был статичным, сам поисковик постоянно менялся, претерпев ни много ни мало 600 пересмотров за год, что в расчет не принималось. Многие другие авторы редакционных статей также высказались по данному вопросу. Большинство из них обращали внимание на взаимосвязи вместо причинно-следственных связей и на критическое отсутствие контекста. Критиковали и методы выборки, так как краудсорсинг ограничивался теми, кто выполнял поиск в Google.

Кроме того, наблюдалась серьезная аналитическая проблема: GFT проводила столько многочисленных сравнений данных, что была вероятность получения случайных результатов. Все это можно рассматривать как обычные ловушки, когда мы пытаемся понять мир через данные. Как написали Кренчел и Мадсбьерг в Wired: «Высокомерие больших данных состоит не в том, что мы слишком уверены в наборе алгоритмов и методов, которых еще в общем-то нет. Скорее проблема в слепой вере в то, что достаточно, сидя за компьютером, перемалывать цифры, чтобы понять окружающий нас мир во всей его полноте». Нам нужны ответы, а не просто данные. Тим Харфорд выразился в Financial Times без обиняков: «Большие данные уже здесь, но великих озарений нет».

Некоторые принялись защищать GFT, указывая, что данные были всего лишь дополнением к санитарно-эпидемиологическим центрам, а Google никогда не заявляла, что обладает магическим инструментом. Наиболее взвешенную точку зрения выразили Гари Маркус и Эрнест Дэвис в своей статье «Восемь (нет, девять!) проблем с большими данными» (Eight (No, Nine!) Problems With Big Data)20. Я уже обращался ко многим их выводам, но мнение Маркуса и Дэвиса насчет беззастенчивой рекламы больших данных и относительно того, что большие данные могут (и чего не могут), заслуживает особого упоминания: «Большие данные повсюду. Кажется, что все их собирают, анализируют, делают на этом деньги и прославляют их силу или боятся их… Большие данные никуда не денутся, как и должно быть. Но давайте будем реалистами: это важный ресурс для всех, кто анализирует данные, а не серебряная пуля»20. Несмотря на проблемы с GFT, подобные шаги никуда не ведут. Альтернативный и более поздний подход — это предсказание вспышки заболеваемости с использованием меньшей базы людей, которые активно поддерживали связь в Twitter, — так называемых «центральных узлов», когда люди по сути выступают в качестве датчиков. Это позволило обнаружить вспышки вирусных заболеваний на семь дней быстрее, чем когда рассматривалось население в целом.

Точно так же алгоритм HealthMap, который проводит поиск в десятках тысяч социальных сетей и новостных СМИ, смог предсказать вспышку лихорадки Эбола в 2014 г. в Западной Африке на девять дней раньше Всемирной организации здравоохранения. Я углубился в историю, связанную с Google и гриппом и вспышками заразных болезней, потому что они отображают ранние этапы пути, по которому мы идем, и показывают, как мы можем заплутать, используя большие массивы данных для предсказаний в медицине. Но знать, как мы сбились в пути, важно, если мы собираемся по нему двигаться.

Рис. 13.3. Google Flu Trends переоценила грипп. Flu Near You («Грипп рядом с вами») — еще одна инициатива, запущенная в 2011 г. Источник: D. Butler, “When Google Got Flu Wrong,” Nature 494 (2013): 155–156. Перепечатывается с разрешения

Рис. 13.3. Google Flu Trends переоценила грипп. Flu Near You («Грипп рядом с вами») — еще одна инициатива, запущенная в 2011 г. Источник: D. Butler, “When Google Got Flu Wrong,” Nature 494 (2013): 155–156. Перепечатывается с разрешения

Предсказания на индивидуальном уровне

По сравнению с данными по всему населению, как в случае Google Flu Trends, более мощный эффект достигается комбинацией детальных данных отдельного человека с детальными данными остального населения. Вы уже сталкивались с этим раньше. Например, компания Pandora располагает базой данных с предпочитаемыми песнями по более чем 200 млн зарегистрированных пользователей, которые в общей сложности нажали на кнопки «нравится» или «не нравится» свыше 35 млн раз. В компании знают, кто слушает музыку, когда ведет машину, у кого Android, а у кого iPhone и где живет каждый из них. В результате можно предсказать не только какая музыка понравится слушателю, но даже его политические предпочтения, и компания уже использовала это в целевой политической рекламе во время президентской избирательной кампании и выборов в конгресс. Эрик Бишке, главный научный сотрудник Pandora, cчитает, что их программы по сбору данных позволяют проникнуть в самую суть своих пользователей. И это действительно так, поскольку, чтобы дойти до сути, они интегрируют два слоя больших данных — ваши данные и данные миллионов других людей.

Используя компании, торгующие данными, типа Acxiom (которые обсуждались в предыдущей главе), Медицинский центр Питтсбургского университета проводит углубленный анализ данных своих пациентов, включая характерное поведение во время шопинга, для предсказания вероятности пользования услугами пунктов оказания первой помощи. Подобным образом поступает и Организация здравоохранения Северной и Южной Каролины, собирая данные о кредитных картах клиентов — 2 млн человек в своем регионе, чтобы определить пациентов с высокой степенью риска заболеваний (например, через покупки фастфуда, сигарет, спиртных напитков и лекарств). Предиктивная модель, используемая в Питтсбурге, показала, что потребители, которые делают больше всего покупок через Интернет и заказывают товары по почте, чаще обращаются в пункты оказания первой помощи, чего организации здравоохранения отнюдь не приветствуют. Обнаруженные взаимосвязи со временем обрастают новыми подробностями, когда информация о нынешних пациентах поступает повторно и большее количество пациентов включается в систему, чтобы лучше предсказывать определенные процессы. Но вопросы конфиденциальности и этичности остаются.

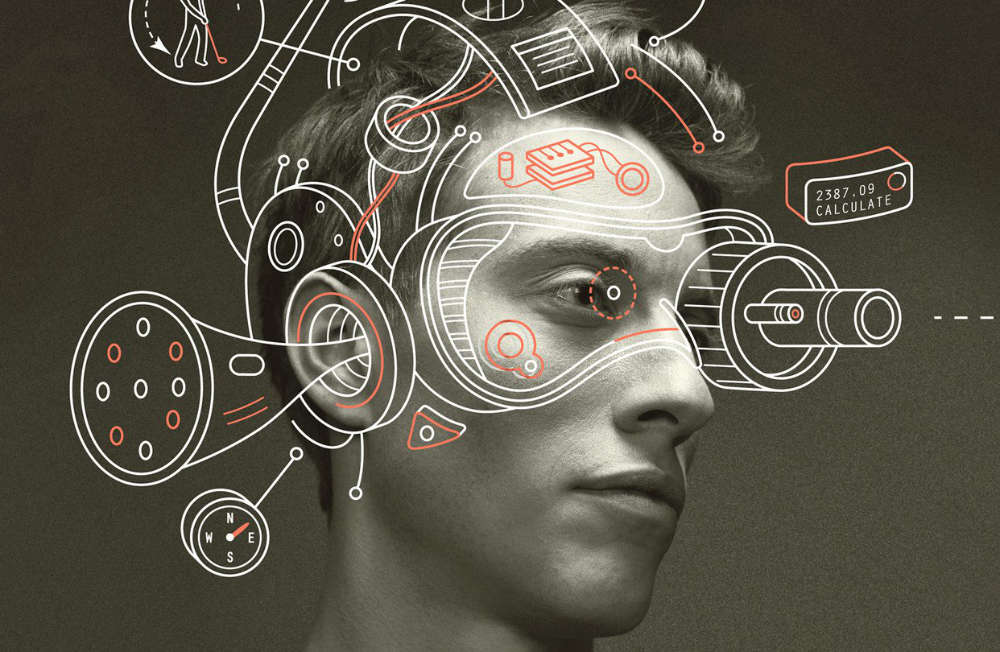

Эти примеры могут рассматриваться как рудиментарная форма искусственного интеллекта — машин или программного обеспечения, демонстрирующих интеллект, подобный человеческому. Другие примеры, которые, возможно, уже окружают вас, включают личных цифровых помощников типа Google Now, Future Control, Cortana и SwiftKey, которые сводят информацию из электронных писем, СМС, ежедневников, записных книжек, истории поисковых запросов, местоположений, покупок, того, с кем вы проводите время, ваших пристрастий в искусстве и вашего поведения в прошлом. Основываясь на том, что они узнают из этой информации, эти приложения появляются на вашем экране, чтобы напомнить о предстоящей встрече, показать пробки на вашем маршруте или сообщить новости по поводу вашего авиарейса. Читая то, что пишут в Twitter, Future Control ваши друзья, вам могут дать совет: «Ваша девушка грустит, пошлите ей цветы». SwiftKey даже вычисляет ваши ошибки при наборе текста и исправляет их, если вы все время нажимаете не на ту клавишу. Google Now работает с авиалиниями и организаторами мероприятий, чтобы иметь доступ к информации о билетах, и может даже слушать звук вашего телевизора, чтобы заранее обеспечить вас программой телевидения. Как вы можете догадаться, это гораздо более мощные возможности, чем поиск соответствий, приводящий в действие Google Flu Trends, и они имеют непосредственное отношение к медицине.

Такая предсказательная сила полагается исключительно на обучение машин, ключевое свойство искусственного интеллекта. Чем больше данных вводится в программу или компьютер, тем большему они учатся, тем лучше алгоритмы и, предположительно, тем умнее они становятся.

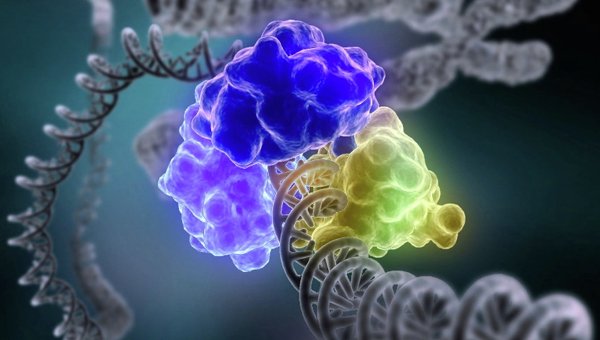

Техники обучения машин и искусственного интеллекта — это то, что обеспечивало триумф суперкомпьютера IBM Watson над людьми в телевикторине Jeopardy! (Рискуй!). Требовалось быстро отвечать на сложные вопросы, ответы на которые не найти с помощью поисковика Google. IBM Watson были обучены ответам на сотни тысяч вопросов, которые задавались в предыдущих играх-викторинах Jeopardy!, вооружены всей информацией из Википедии и запрограммированы на предиктивное моделирование. Здесь не предсказание будущего, а просто предсказание того, что у IBM Watson есть правильный ответ. В основе предсказательных возможностей суперкомпьютера был внушительный портфель систем для обучения машин, включая сети Байеса, цепи Маркова, метод опорных векторов и генетические алгоритмы. Не стану больше в это углубляться: я недостаточно умен, чтобы все это понять, и, к счастью, это не особо относится к тому, куда мы с вами сейчас идем. Еще один подвид искусственного интеллекта и обучения машин, известный как глубинное обучение, имеет важное значение для медицины.

Глубинное обучение стоит за способностью Siri декодировать речь, как и за экспериментами Google Brain с распознаванием образов. Исследователи из Google X извлекли из видеозаписей на YouTube 10 млн изображений и запустили их в сеть из 1000 компьютеров, чтобы посмотреть, что Google Brain, обладающий миллионом моделируемых нейронов и миллиардом моделируемых синапсов, способен предложить самостоятельно. Ответ — кошек. Интернет, по крайней мере сегмент YouTube (который занимает весьма существенную его часть), полон видеозаписей кошек. Кроме опознания кошки это открытие проиллюстрировало когнитивные вычисления, также известные как нейроморфные. Если компьютеры могут соревноваться с человеческим мозгом, как гласит теория, то можно добиться перехода их функциональных возможностей в плане восприятия, действия и понимания на следующий уровень. Прогресс в нейроморфных вычислениях идет с головокружительной скоростью. В прошлом году точность компьютерного зрения — например, распознавание пешехода, шлема, велосипедиста, автомобиля — улучшилась с 23% до 44%, при этом частота ошибок снизилась с 12% до менее 7%.

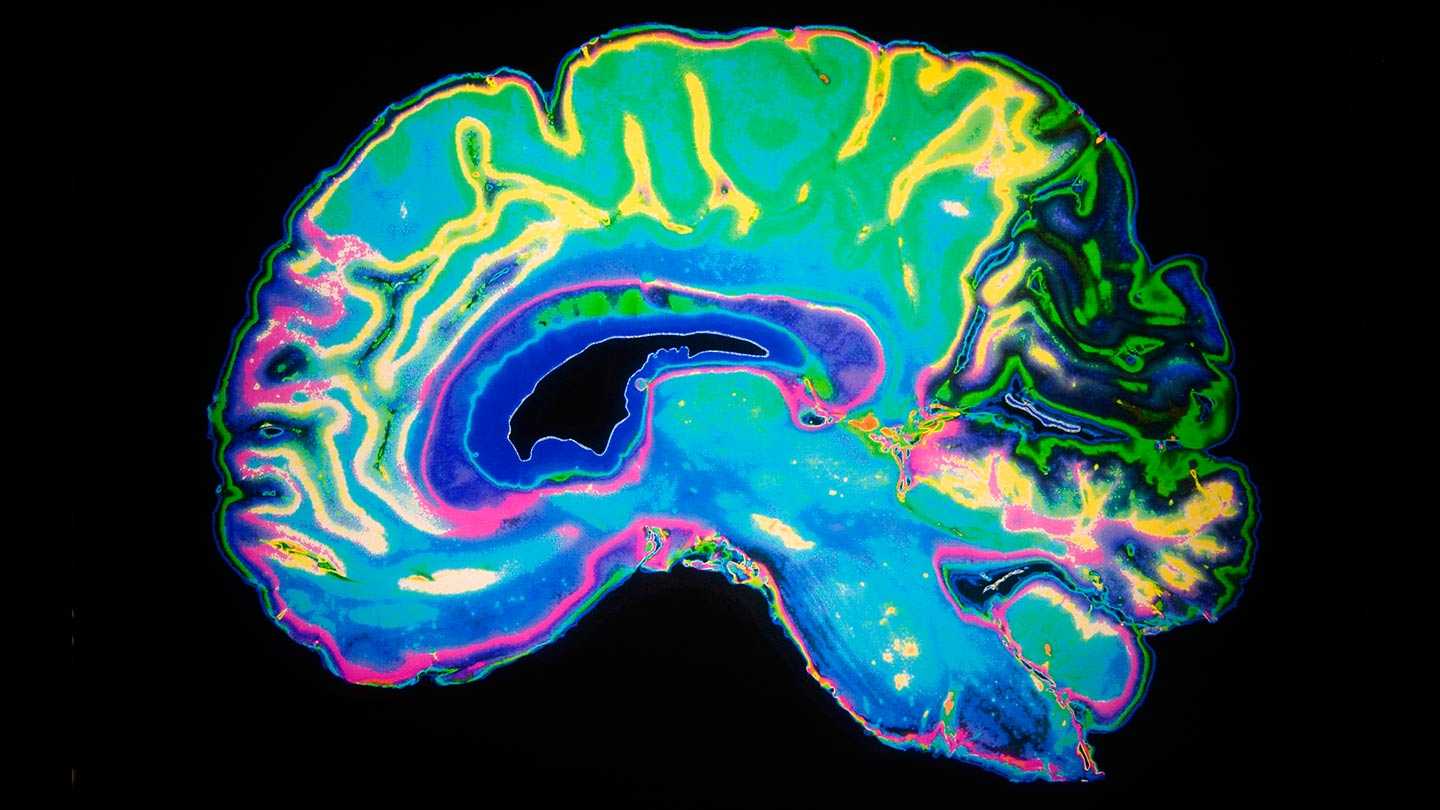

Несмотря на достижения Google Brain, нам пока нечем похвастаться. Человеческий мозг работает на малой мощности, порядка 20 ватт, а суперкомпьютеру требуются миллионы ватт для работы. В то время как мозг не нужно программировать (пусть даже иногда кажется, что он запрограммирован) и он теряет нейроны на протяжении своей жизни без существенного функционального истощения, компьютер, потерявший один-единственный чип, может сломаться, и обычно машины не могут адаптироваться к миру, с которым взаимодействуют. Гари Маркус, нейробиолог из Нью-Йоркского университета, так сформулировал эту нейроморфную задачу в перспективе: «В такие времена я нахожу полезным вспомнить базовую истину: человеческий мозг — это самый сложный орган во Вселенной, и мы до сих пор не представляем, как он работает. Кто сказал, что копирование его восхитительной мощи будет простым?» Тем не менее наблюдается довольно большой прогресс в распознавании речи, лиц, жестов и снимков, в чем так силен человеческий мозг и слаб компьютер. Я посетил немало конференций и читал лекции в разных странах, с синхронным переводом, и меня особенно поразило одно достижение: Ричард Рашид, возглавлявший некогда научное подразделение в Microsoft, выступал с лекцией в Китае, и компьютер не только синхронно выдавал ее в иероглифах, но и переводил на китайский (смоделированным) голосом самого Рашида. Программа DeepFace от Facebook, с самой большой в мире фотобиблиотекой, может определить, принадлежат ли две фотографии одному и тому же человеку, с точностью в 97,25%. Последствия для медицины очевидны.

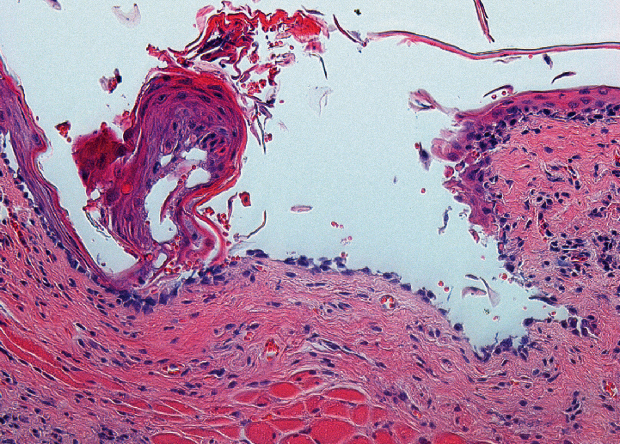

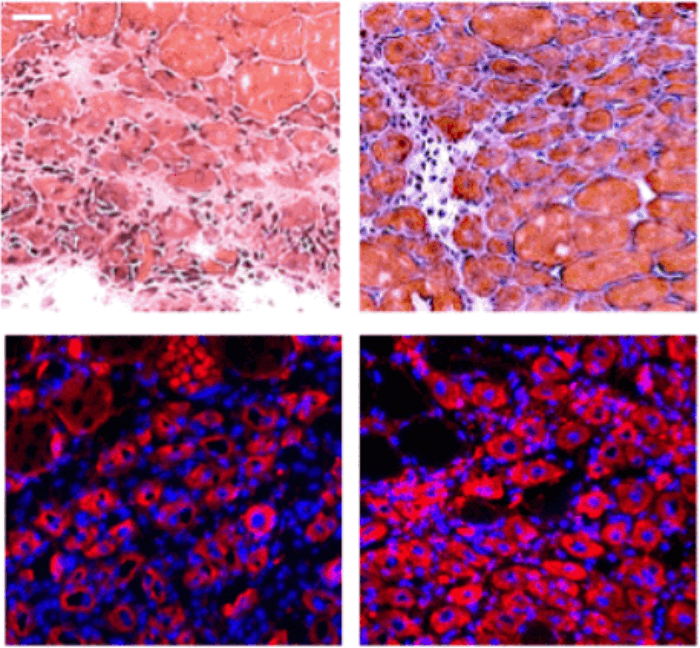

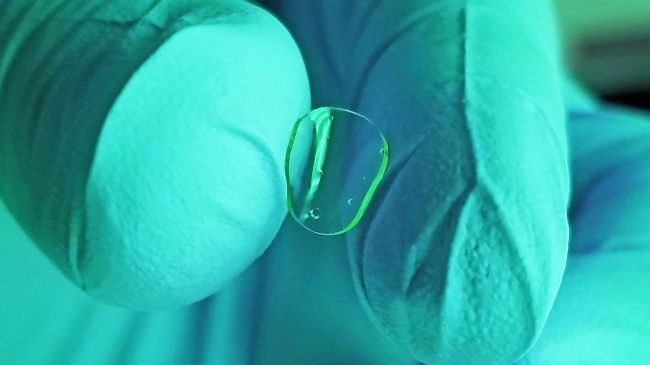

Ученые уже показывают, что компьютеры способны распознавать выражения лиц, например боль, точнее, чем люди, и происходит поразительный прогресс в распознавании лиц компьютерами. Специалисты по информатике из Стэнфордского университета использовали кластер из 1600 компьютеров для подготовки к распознаванию снимков, тренировки проводились на 20 000 различных объектов. Больше к нашей теме относится то, что они использовали инструменты глубинного обучения для определения, является ли образец, взятый при биопсии в случае рака груди, злокачественным. Эндрю Бек из Гарвардского университета разработал компьютеризованную систему для диагностики рака груди и прогнозирования шансов на выживание, основываясь на автоматической обработке снимков. Оказалось, что обучение на основе обработки данных в ЭВМ обеспечивает большую точность в сравнении с патологами, и это помогло распознать новые особенности, остававшиеся незамеченными на протяжении многих лет. И нам не следует забывать об активной поддержке развития искусственного интеллекта, которая позволила создать видящие и слышащие устройства. Камера-датчик Orcam устанавливается на очках слабовидящих людей, она видит предметы и передает эту информацию через наушник, используя костную проводимость. Слуховые аппараты GN ReSound Linx и Starkey — это подключаемые к смартфону приложения, которые «обеспечивают людям, потерявшим слух, возможность слышать лучше тех, кто нормально слышит».

Есть инвалидные кресла для людей без четырех конечностей, контролируемые мыслью, в духе бионического будущего. Поэтому способность искусственного интеллекта преображать вещный мир в медицине нельзя упускать из виду. Конечно, технологии могут легко соединяться с робототехникой. В Калифорнийском университете в Сан-Франциско больничная аптека полностью автоматизирована, и роботизированная выдача лекарственных препаратов пока происходит без единой ошибки.

30.06.2016 Источник: postnauka.ru